論文メモ:人間とAIの協調性の改善、トークン化、変化要因を制御した言語間の転移分析、デルタチューニングを体系的な調査・定義

💡 概要

- 人間の行動をモデル化し最適化することで人間とAIの協調性を改善

- トークン化、形態素や構文などの要因を制御した言語間の転移分析

- デルタチューニングを体系的に定義し100以上のNLPタスクで調査

人間の行動をモデル化し最適化することで人間とAIの協調性を改善

タイトル: Uncalibrated Models Can Improve Human-AI Collaboration

著者:Kailas Vodrahalli, Tobias Gerstenberg, James Zou

会議・出版: arXiv

年: 2022

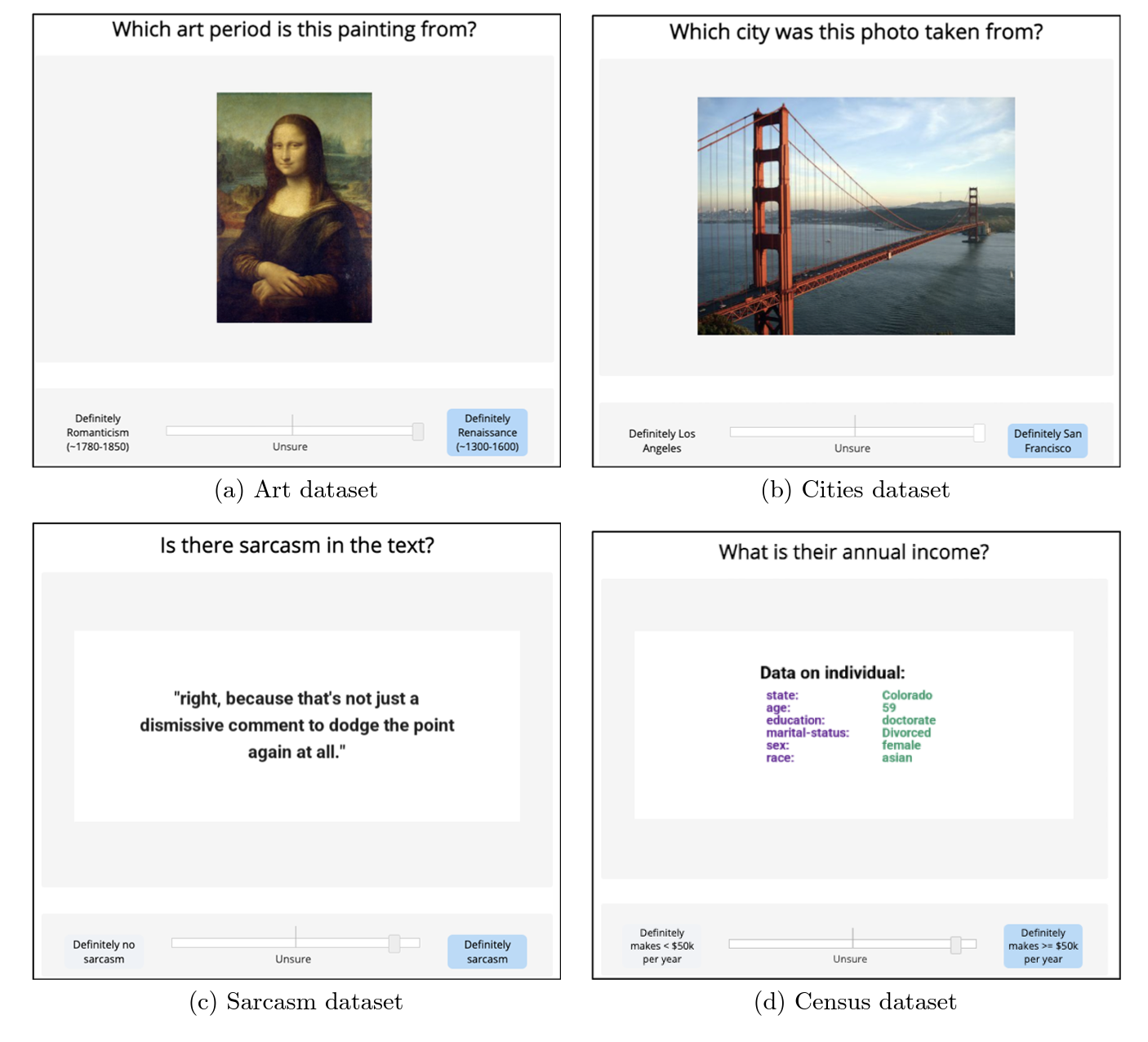

AIを用いた多くのアプリケーションにおいて、AIは人間のユーザの決定の補助として使われる。AIは人間が意思決定プロセスに組み込むようなアドバイアスを提供する。AIのアドバイスはよく人間がアドバイアスをどらくらい依存または信頼できるかをcalibrateするために使う「信頼度」の指標と共に提示される。

この論文では、もともとのAIが十分にcalibrateされたときでさ、AIを実際よりも自信を持ってアドバイアスを提示することで、人間とAIの性能を改善できることを示す。AIのアドバイスを見た後の人間の最終的な予測の性能と信頼度により評価される。

まず、どのように人間がAIのアドバイスを組み込むか数千の人間との対話データを使いモデルを学習する。これは最終的な人間の予測を改善するために、どのようにAIの予測の信頼度を変換し、AIをuncalibrateさせるかを明確に評価することを可能にする。

数百人の人間の参加者が含まれたデータを含む画像、テキストと表形式のデータを扱う4つの異なるタスクにおいて結果を実験的に検証する。さらに、シミュレーション分析により結果をサポートする。この論文は重要な。AIモデルだけを最適化する一般的なパラダイムに対して人間とAIシステムを同時に最適化することの重要性とそのフレームワークを提案している。

トークン化、形態素や構文などの要因を制御した言語間の転移分析

タイトル: Oolong: Investigating What Makes Crosslingual Transfer Hard with Controlled Studies

著者:Zhengxuan Wu, Isabel Papadimitriou, Alex Tamkin

会議・出版: arXiv

年: 2022

トークン化、形態素や構文などの要因が言語間で一度に変化するため、何が言語間の転移を難しくしているかはほとんどわかっていない。これらの要因の影響を紐解くために、この論文では制御された転移調査を提案する。GLUEタスクを系統的に変形させ、異なる要因を一つずつ変化させ、その結果生じる学習済みモデルの下流性能の低下を測定する。

知識転移に対する構文からの影響は少ないとする既存研究とは対照的に、我々は構文のシフトによる大きな影響を発見した。一方で、モデルは小規模なデータでの継続的な事前学習によりすぐに適応する。しかしながら、既存の層と新しい埋め込みを整合させることが言語間の転移において最も影響のある要因であり、トークン化やや形態素の変更による追加効果はほとんどないことを発見した。さらに、小規模データで事前学習を継続することは提示されたギャップを減らすのにほとんど効果的ではなく、この問題を解決するには新しい方向性が必要であることを示唆している。

デルタチューニングを体系的に定義し100以上のNLPタスクで調査

タイトル: Delta Tuning: A Comprehensive Study of Parameter Efficient Methods for Pre-trained Language Models

著者:Ning Ding, Yujia Qin, Guang Yang, Fuchao Wei, Zonghan Yang, Yusheng Su, Shengding Hu, Yulin Chen, Chi-Min Chan, Weize Chen, Jing Yi, Weilin Zhao, Xiaozhi Wang, Zhiyuan Liu, Hai-Tao Zheng, Jianfei Chen, Yang Liu, Jie Tang, Juanzi Li, Maosong Sun

会議・出版: arXiv

年: 2022

事前学習言語モデルはさまざまなNLPタスクにおける基盤技術となっており、新しい研究の証拠は継続的に大規模なモデルが良い性能であることを証明している。しかし、歓迎すべき結果であるにもかかわらず、大規模な事前学習言語モデルのファインチューニングには法外なコストがかかる。実際、巨大なモデルのパラメータ全てをファインチューニングすることと異なるタスクのために分割されたインスタンスを再学習することは非常に難しい。これは事前学習言語モデルのパラメータの効率的な活用に焦点を当てた新しい研究分野が必要となる。

パラメータ効率に限らず、そのような手法の可能性を解き放つために、この論文では本来の「効率的パラメータチューニング」に対して、形態学的観点から新しい用語「デルタチューニング」を造る。一般的なファインチューニングとは対照的に、デルタチューニングは一部のモデルパラメータのみをファインチューニングし、一方で残りのパラメータはそのままにすることで、計算とメモリ両方のコストを大幅に削減する。最近の研究では、パラメータを明確に選択するデルタチューニングが、全てのパラメータをファインチューニングした場合と同等の性能を達成できることが実証されている。これにより、デルタチューニングが大規模な事前学習モデルを活気づける新しい有望な方法であることが示唆されている。

この論文では、初めて正式にデルタチューニングの問題を説明し、包括的に最新のデルタチューニング手法を調査する。さらに、既存のデルタチューニングをaddition-based, specification-basedとreparameterization-basedの3つのグループに分類する統一的なカテゴリー基準を提案する。当初は大規模モデルを扱う効率的手法として提案されたが、デルタチューニングと共に発見された知見は事前学習言語モデルとニューラルネットワークの仕組みをさらに明らかにすることを助けると考える。この目的を達成するために、デルタチューニングの有効性を支える理論的な原則について議論し、最適化と最適制御の観点からデルタチューニングを解釈する枠組みをそれぞれ提案する。

さらに、代表的な手法の全体的な実験を行い、100以上のNLPタスクに関する結果は異なる手法の包括的な性能比較を示す。デルタチューニングの組み合わせ特性、スケーリング特性や転移特性についての分析も実験結果は網羅している。デルタチューニングの研究を容易にするために、ユーザーが事前学習言語モデルにおけるデルタチューニングを効率的にそして柔軟に実装を可能にするオープンソースツール「OpenDelta2」を開発する。最後に、デルタチューニングの現実世界のアプリケーションでのシナリオを議論する。